Для того, чтобы страницы сайта занимали лидирующие позиции в выдаче, они должны быть проиндексированы поисковиками. Если этого не произошло, то и трафика на вашем ресурсе не будет. А чтобы исправить ситуацию, нужно сначала разобраться, почему не индексируется сайт. Чаще всего причиной являются технические ошибки, которые нужно найти и устранить. Чтобы таких проблем не возникало, лучше с самого начала доверить работу над сайтом опытным SEO-специалистам. Сотрудники нашей компании JamIT в Ульяновске создадут сайт любой тематики, от простого до самого сложного, и обеспечат его продвижение в поисковиках.

Мы поможем исправить и ошибки в уже существующем сайте. Эксперты нашей компании JamIT расскажут, с какими проблемами можно столкнуться при индексации и помогут их решить.

Сколько времени занимает индексация в Google и Яндекс?

У каждой поисковой системы свои алгоритмы работы. Добавление новых страниц в поисковую выдачу Яндекса происходит несколько раз в месяц. Но, если ваш сайт существует уже давно, и относится к числу авторитетных, то индексация происходит значительно быстрее. Тогда практически сразу после публикации новые, проиндексированные Яндексом страницы сайта попадают в выдачу.

Google работает иначе. Но и для этого поисковика скорость индексации напрямую зависит от авторитетности сайта, а также от того, как часто там обновляется контент. Например, если ресурс популярен, новые публикации выходят постоянно, поисковые роботы чаще бывают на таких страницах. В таком случае будут проиндексированы даже материалы, которые были опубликованы всего несколько часов назад. Однако в среднем процесс индексации в этой поисковой системе занимает 2-4 дня, а новые сайты могут быть обработаны даже через несколько недель.

Если все отведенные на это сроки давно прошли, а Яндекс или Гугл не индексирует страницы по-прежнему, нужно разбираться, в чем состоит причина. Начать проверку можно даже через две недели после того, как сайт или страница запустились в работу. Лишними эти усилия не будут.

Какие виды сайтов чаще всего сталкиваются с проблемами с индексацией?

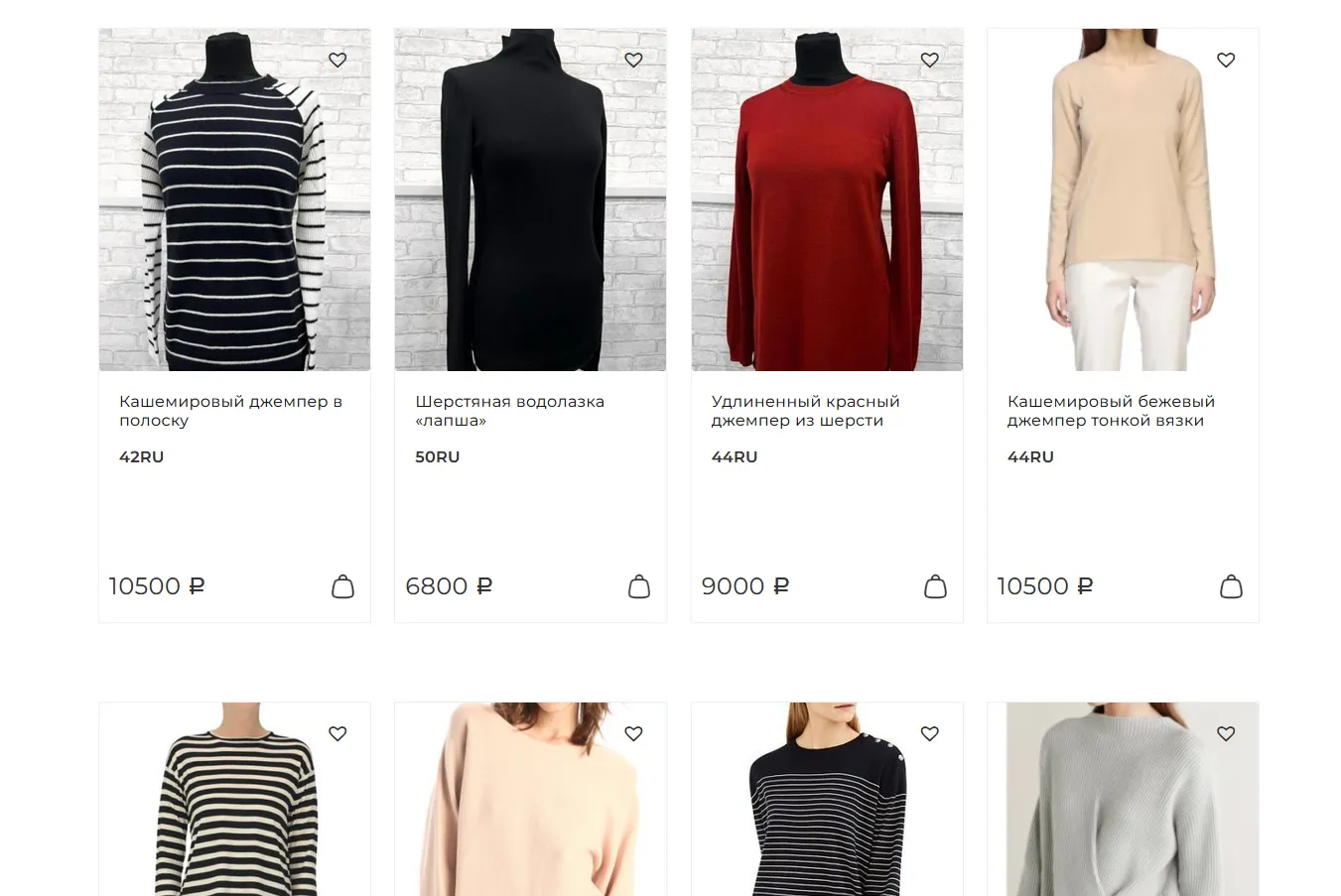

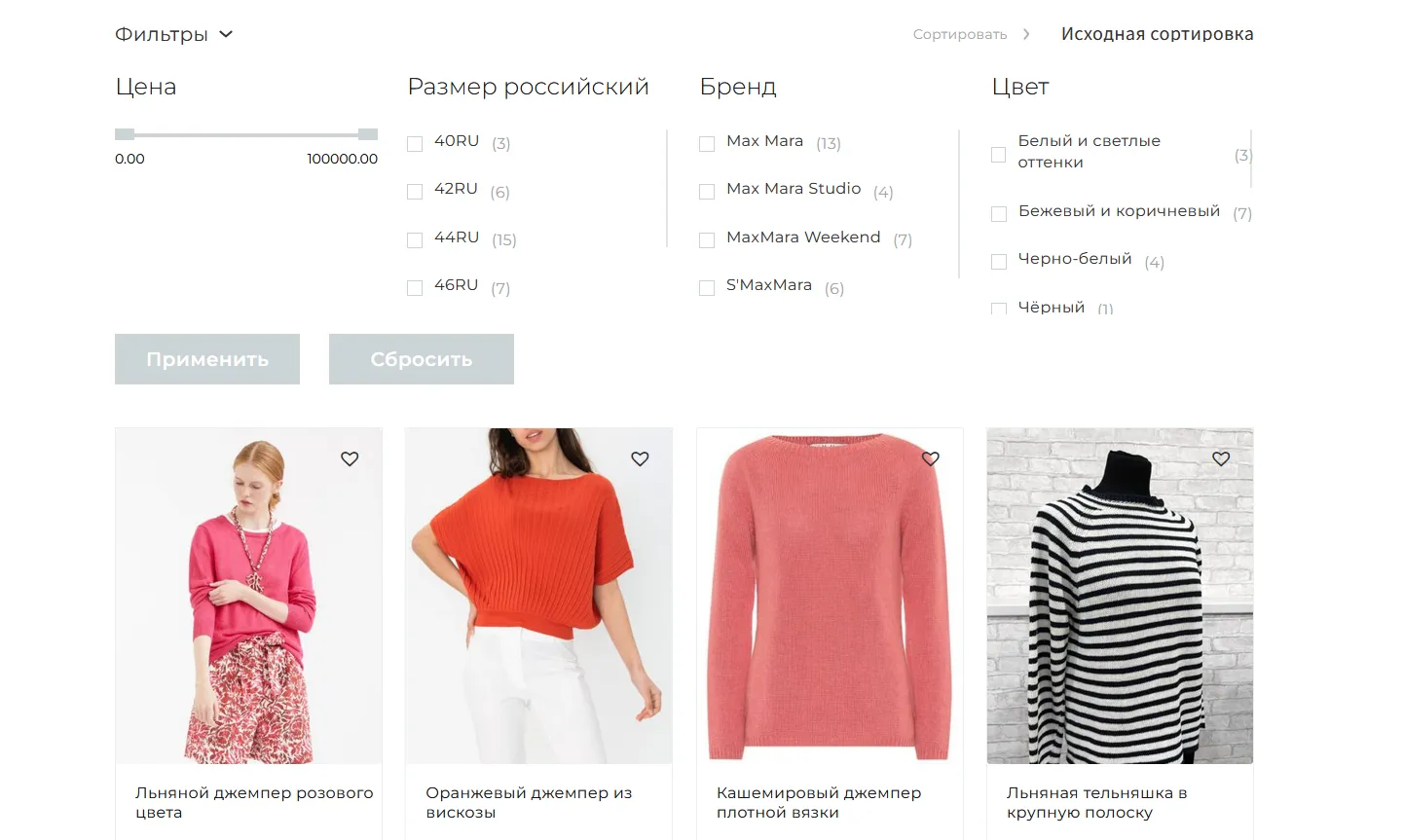

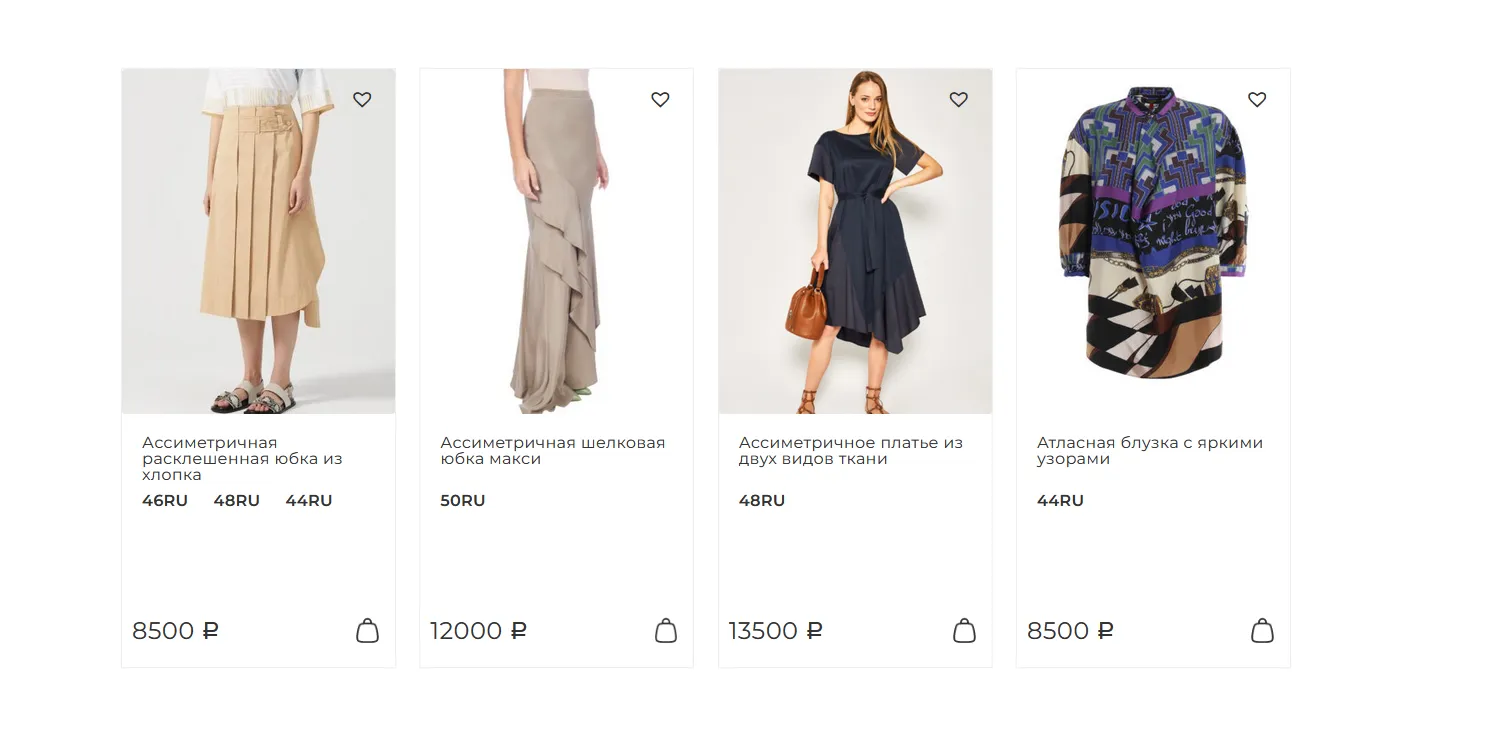

Часто индексация страниц сайта в Яндекс и Гугл зависят от вида самого ресурса. Чаще всего с проблемами сталкиваются онлайн-магазины и информационные сайты, в которые постоянно добавляются новые блоки.

Что мешает индексации?

Три основные причины — это ошибки в технической оптимизации сайта (в том числе неправильные настройки, нерабочие ссылки, наличие дублей страниц, отсутствие внутренней перелинковки, низкая скорость загрузки), особенности алгоритмов поисковых систем и низкое качество страниц. В каждом конкретном случае придется узнавать, почему Гугл не индексирует страницы сайта и принимать соответствующие меры. Например, чтобы понять, почему система считает качество страниц низким, нужно проанализировать сайты конкурентов, попадающие в первую десятку поисковой выдачи, и внедрить у себя похожие решения. А лучше поручить эту работу SEO-специалистам, потому что они справятся с ней быстрее и с более высокой результативностью.

Какие инструменты можно использовать для проверки индексации?

Чтобы понять, почему сайт не индексируется в Яндексе, можно воспользоваться теми инструментами, что имеются в Яндекс.Вебмастер. Для Гугла это соответственно будет Google Search Console. В последнем данные обновляются не так часто, как хотелось бы, поэтому эксперты рекомендуют использовать и сторонние инструменты, например, Rush Analytics.

Что делать, если страницы вообще не индексируются?

Это может происходить по нескольким причинам, обязательно нужно проверить, все ли было сделано правильно.

Поисковики не видят сайт

Если ресурс только запустили, и сайт не индексируется в Яндексе и Гугле, то возможно, поисковики его не замечают по техническим причинам. Это бывает, если владелец не сообщил о наличии нового сайта, то есть не добавил его в Яндекс.Вебмастер (или аналогичную консоль Google).

Это можно легко исправить. Чтобы добавить сайт в Яндекс.Вебмастер, нужно:

- Открыть главную панель.

- Добавить сайт, нажав на значок плюса.

- Указать адрес сайта и подтвердить свои права на него. Последнее можно сделать несколькими способами, например, добавить соответствующую TXT-запись в DNS домена.

Для Google Search Console используется аналогичный алгоритм, только здесь на панели есть кнопка «Добавить ресурс». При этом каждую его страницу добавлять не надо, ни в том, ни в другом случае, достаточно только главной. Когда поисковые боты знают о существовании сайта, они его регулярно проверяют, и индексация происходит быстрее.

Существуют ли другие причины, по которых поисковики не видят сайт?

Такая ситуация может возникать из-за того, что некорректно работает тег noindex. Он закрывает от индексации ненужные страницы, но иногда вместе с ними и нужные, если настроить его неправильно. Поэтому, если описанные выше меры не дали эффекта, нужно проверить этот тег.

Проблемы могут возникать и из-за неправильных приватных настроек в CMS, их также следует проверять.

Другие распространенные технические ошибки — неправильная кодировка, которую бот воспринимает как набор нечитаемых символов, некорректные редиректы, а также проблемы, возникающие при сканировании (поисковые системы обязательно присылают о них уведомления).

Если сайт не индексируется в Google или Яндекс, то причина может быть в том, что не была добавлена карта сайта. Желательно делать это одновременно с добавлением его адреса.

Ботам запретили обход

На каждом сайте должен быть файл robots.txt. В упрощенном виде его можно представить как инструкцию для поисковых ботов, которая рассказывает, на какие страницы можно заходить, а на какие нет. Этот файл нужен для того, чтобы в индексацию не попадали:

- служебные файлы;

- дубли страниц;

- параметрические страницы и т.д.

Но этот файл важно правильно настроить. Иначе он вообще не будет пускать поисковых ботов, то есть индексация проводится не будет.

Если на сайте этого файла нет, его нужно создать и загрузить на сервер. Если файл есть, его нужно проверить и убедиться в том, что запрет на индексацию отсутствуют.

Обязательно нужно проверить файл htaccess. Если в нем есть строчка вроде «SetEnvIfNoCase User-Agent «^Googlebot» search_bot», это означает запрет на индексацию для ботов Гугла. Обычно такая же строчка есть и для Яндекса. Их нужно удалить, чтобы индексация заработала нормально.

Похожая проблема возникает, если есть запрет в HTTP-заголовке X-Robot-Tag. Для его проверки используется специальный инструмент.

Проблемы с хостингом или работой веб-площадки

Одна из причин, почему Яндекс или Гугл не индексирует страницы, заключается в плохой работе самого сайт. Часто это связано с их медленной загрузкой. Проверяют работу сайта с помощью инструментария самих поисковиков или сторонних сервисов вроде PageSpeed Insights.

Причиной могут быть проблемы с хостингом страницы. Из-за сбоев в работе страницы сайта часто оказываются недоступны для поисковиков, и боты реже на них приходят, а через какое-то время начинают полностью игнорировать.

Проверять стоит все возможности. Например, ошибки в HTML-разметке или проблемы с индексацией JavaScript, когда нет статичного кода, тоже могут приводить к отсутствию индексации.

Почему не индексируются страницы низкого качества?

Это не связано с санкциями, которые поисковые системы накладывают при неуникальном контенте. Низкое качество означает, что у вашего ресурса оно хуже по сравнению с конкурентами, например, контент плохо оптимизирован, много технических ошибок, используются одинаковые мета-теги и структуры заголовков. Чтобы этого не произошло, обратитесь к SEO-специалистам нашей студии JamIt, которые смогут исправить ошибки и повысить качество контента.

Что делать, если страницы не индексируются конкретным поисковиком?

Бывает так, что с технической точки зрения все в порядке, но один из поисковиков как будто не видит ваш ресурс. Почему Гугл не индексирует страницы сайта или почему их игнорирует Яндекс — потому что поисковая система наложила санкции на эту веб-площадку. Обычно о таких санкциях предупреждают системы типа упомянутых Вебмастера и Консоли, но не всегда владелец ресурса обращает внимание на письмо.

У каждой системы есть свои принципы в отношении санкций. Например, почему сайт не индексируется в Гугле — ресурс ставит слишком много внешних ссылок, которые тематически никак с ним не связаны (так называемые ссылочные помойки), цитирует сайты, которые считаются некачественными и т.д. Переоптимизация, с заспамленностью ключами, тоже может стать поводом для санкций. У Яндекса есть санкции за обман пользователей и поисковой системы (например, кликджекинг). Наказывают и за накрутку поведенческих факторов, то есть за переходы, которые Яндекс считает неестественными. В любом случае ресурс нужно будет проверять, и лучше, чтобы этим занялся SEO-специалист, который сможет сразу исправить ошибки.

К бану, помимо переоптимизированного семантического ядра, приводят:

- большое количество нерелевантного контента, который не связан с основной тематикой сайта;

- большое количество рекламных блоков;

- наличие вредоносного кода.

Иногда в бане оказывается сам домен (это случается, если его владельцы злоупотребляли черными методами продвижения или каким-либо иным способом нарушали правила поисковиков). Поэтому перед покупкой нужно разобраться, кому он принадлежал и как выглядел, чтобы потом не искать, почему Яндекс не индексирует сайт. Для проверки истории домена существуют бесплатные сервисы типа whois.domaintools.com.

Какими способами можно ускорить индексацию?

Владельцев ресурсов интересует, как ускорить индексацию сайта в Google и Яндексе. Это можно сделать различными способами. Самый надежный из них — это создание уникального и убедительного контента, которого не будет у конкурентов. Но на практике всегда кто-то будет опережать и внедрять интересные идеи быстрее, поэтому нужно заниматься также технической стороной.

Можно предпринять такие меры:

- Отправить непроиндексированную страницу на переобход (в Яндекс.Вебмастере эта функция так и называется, в GSC — это Инструмент проверки URL).

- Проверить, насколько корректно Яндекс или Гугл отображает сайт. Помимо прямого запрета в файле robot.txt, ошибки могут быть связаны с использованием JavaScript.

- Проработать внутреннюю перелинковку сайта и его структуру. Чем выше степень перелинковки, тем больше вероятность быстрой индексации страниц. Потому что, если страница попадает в «тупиковую зону», поисковые боты считают ее недостаточно значимой. Обязательно должна быть ссылка на «родительскую категорию», а также на какую-либо из страниц сайта, связанных тематически.

- Регулярно обновлять контент, добавлять что-то новое, актуализировать старые блоки (чем чаще это делается — тем чаще поисковые боты проверяют страницу и тем выше скорость индексации).

- Обеспечить наличие и корректность файла карты сайта (sitemap.xml). Если она будет генерироваться при запросе, то это будет занимать много времени и снижать скорость загрузки. Вариант решения — карту можно сделать статической, обновляться она будет с заданной периодичностью по мере появления новых страниц.

Хотя все эти меры можно принять самостоятельно, они требуют теоретических знаний и практических навыков работы с сайтом, а еще — времени, которое владелец мог бы потратить на решение более важных бизнес-задач. Чтобы не терять это время и не тратить деньги на создание собственное подразделения, занятого работой с сайтом, проще передать эту функцию на аутсорсинг. Наша компания JamIT предлагает полный комплекс услуг по SEO продвижению сайта. Чтобы заключить договор на эту услугу, звоните или оставляйте заявку на сайте.